- Հեղինակ Lynn Donovan [email protected].

- Public 2023-12-15 23:48.

- Վերջին փոփոխված 2025-06-01 05:08.

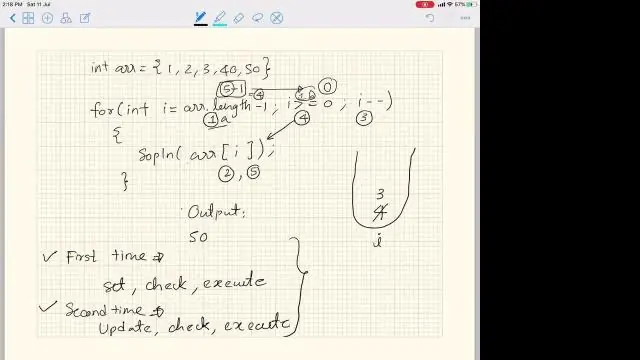

Փաստաթղթերից՝ CLASS ջահ: nn . Գծային (in_features, out_features, bias=True) Կիրառվում է a գծային փոխակերպում մուտքային տվյալների՝ y = xW^T + b. Պարամետրեր. in_features - յուրաքանչյուր մուտքային նմուշի չափը:

Նմանապես, հարցնում են՝ ինչպե՞ս է աշխատում NN գծայինը:

Գծային . Կիրառվում է ա գծային փոխակերպում մուտքային տվյալներին, այսինքն. //y= Ax+b//: Forward(input)-ում տրված մուտքային տենզորը պետք է լինի կամ վեկտոր (1D թենզոր) կամ մատրիցա (2D տենզոր): Եթե մուտքագրումը մատրիցա է, ապա յուրաքանչյուր տող ենթադրվում է որպես տվյալ խմբաքանակի մուտքային նմուշ:

Նմանապես, ի՞նչ է conv2d-ը PyTorch-ում: conv2d (ներածում, քաշ, ես. կողմնակալություն, ես. քայլ, ես. լիցքավորում, ես. լայնացում, ես.

Երկրորդ, ինչ է PyTorch nn-ը:

PyTorch : nn Այն nn փաթեթը սահմանում է մոդուլների մի շարք, որը դուք կարող եք պատկերացնել որպես նեյրոնային ցանցի շերտ, որն արտադրում է ելք մուտքից և կարող է ունենալ որոշ վերապատրաստվող կշիռներ: ներմուծման ջահը # N խմբաքանակի չափն է; D_in-ը մուտքային չափն է; # H-ը թաքնված հարթություն է; D_out-ը ելքային չափն է:

Ինչպե՞ս եք օգտագործում ReLU-ն PyTorch-ում:

Մեջ PyTorch , կարող եք կառուցել ա ReLU շերտ օգտագործելով պարզ ֆունկցիա relu1 = nn: ReLU inplace=False արգումենտով: Քանի որ ReLU ֆունկցիան կիրառվում է տարրական առումով, կարիք չկա նշելու մուտքային կամ ելքային չափերը: Inplace արգումենտը որոշում է, թե ֆունկցիան ինչպես է վերաբերվում մուտքագրմանը:

Խորհուրդ ենք տալիս:

Ի՞նչ է գծային և ոչ գծային տվյալների կառուցվածքում:

1. Տվյալների գծային կառուցվածքում տվյալների տարրերը դասավորված են գծային կարգով, որտեղ յուրաքանչյուր տարր կցվում է իր նախորդ և հաջորդ հարակիցներին: Տվյալների ոչ գծային կառուցվածքում տվյալների տարրերը կցվում են հիերարխիկ ձևով: Տվյալների գծային կառուցվածքում տվյալների տարրերը կարող են անցնել միայն մեկ գործարկման ընթացքում

Արդյո՞ք գծային որոնումը նույնն է, ինչ հաջորդական որոնումը:

Դաս. Որոնման ալգորիթմ

Ո՞րն է առաջին գծային խմբագրման մեքենայի անունը:

Խմբագրման գծային մեթոդը ներառում է պատկերների և ձայների դասավորությունը հերթականությամբ: Սկզբում դա ներառում էր մկրատի օգտագործումը՝ կադրերը միացնելու համար, այնուհետև ժապավենի օգտագործումը՝ դրանք ճիշտ հերթականությամբ ամրացնելու համար: Նման մեթոդները կիրառվում էին մինչև 1920-ական թվականները, երբ հայտնագործվեց առաջին խմբագրման մեքենան, որը կոչվում էր Moviola:

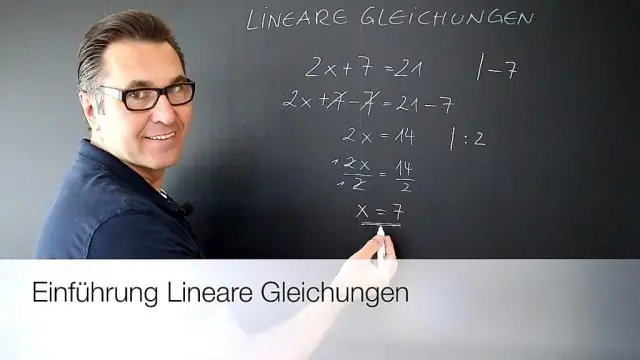

Ի՞նչ է կանոնավոր գծային ռեգրեսիան:

Կանոնավորեցում. Սա ռեգրեսիայի ձև է, որը կաշկանդում/կարգավորում կամ կրճատում է գործակիցների գնահատականները մինչև զրոյի: Այլ կերպ ասած, այս տեխնիկան չի խրախուսում ավելի բարդ կամ ճկուն մոդել սովորելը, որպեսզի խուսափի չափից ավելի հարմարվելու վտանգից: Գծային ռեգրեսիայի պարզ կապն այսպիսի տեսք ունի

Ո՞րն է գծային բլոկի կոդի սահմանումը:

«Գծային բլոկային ծածկագիրը բլոկային ծածկագիր է, որտեղ բացառապես կամ ցանկացած երկու կոդային բառից ստացվում է մեկ այլ ծածկագիր