- Հեղինակ Lynn Donovan [email protected].

- Public 2023-12-15 23:48.

- Վերջին փոփոխված 2025-01-22 17:27.

Ռելու : Հաշվարկելու համար ավելի արդյունավետ քան սիգմոիդը նման գործառույթներ, քանի որ Ռելու պարզապես անհրաժեշտ է topk max(0, x) և չկատարել թանկարժեք էքսպոնենցիալ գործողություններ, ինչպես Sigmoids-ում: Ռելու Գործնականում ցանցեր հետ Ռելու հակված է ցույց տալ ավելի լավ կոնվերգենցիայի կատարումը քանզիգմոիդ.

Նմանապես կարելի է հարցնել, թե ինչու է ReLU-ն լավագույն ակտիվացման գործառույթը:

Հիմնական գաղափարն այն է, որ գրադիենտը լինի ոչ զրոյական և ի վերջո վերականգնվի մարզումների ժամանակ: ReLu ավելի քիչ հաշվողականորեն թանկ է, քան tanh-ը և սիգմոիդ քանի որ այն ներառում է ավելի պարզ մաթեմատիկական գործողություններ: Այսինքն ա լավ կետ, որը պետք է հաշվի առնել, երբ մենք նախագծում ենք խորը նյարդային ցանցեր:

Կարելի է նաև հարցնել՝ ի՞նչ է սիգմոիդ ակտիվացման ֆունկցիան։ Այն սիգմոիդ ֆունկցիան է ակտիվացման գործառույթ Նեյրոնային ցանցերում նեյրոնների արձակման հետ կառուցված հիմքում ընկած դարպասի առումով: Ածանցյալը նույնպես գործում է a ակտիվացման գործառույթ Նեյրոնի հետ աշխատելու առումով ակտիվացում NN-ների առումով. Նրանց միջև տարբերությունն այն է ակտիվացում աստիճան և փոխազդեցություն:

Նմանապես, ինչու ենք մենք օգտագործում ReLU-ն CNN-ում:

Կոնվոլյուցիոն նեյրոնային ցանցեր ( CNN Քայլ 1(բ) - ReLU Շերտ. The Rectified Linear Unit, or ReLU , է կոնվոլյուցիոն նեյրոնային ցանցերի գործընթացի առանձին բաղադրիչ չէ: Ուղղիչ ֆունկցիայի կիրառման նպատակը է բարձրացնել մեր պատկերների ոչ գծայինությունը:

Ո՞րն է ReLU-ի օգտագործումը:

ReLU (Ուղղված գծային միավոր) ActivationFunction The ReLU ամենաշատն է օգտագործված Ակտիվացման գործառույթն աշխարհում հենց հիմա: Քանի որ դա կա օգտագործված գրեթե բոլոր կոնվոլյուցիոն նեյրոնային ցանցերում կամ խորը ուսուցման մեջ:

Խորհուրդ ենք տալիս:

Արդյո՞ք Tumblr-ն ավելի լավն է, քան Instagram-ը:

Tumblr-ը միկրոբլոգների կայք է, որն այն դարձնում է ավելի բազմակողմանի, քան Instagram-ը: Դուք կարող եք օգտագործել այս սոցիալական մեդիա ցանցային ալիքը՝ կիսվելու տեքստով, պատկերներով, հղումներով, տեսանյութերով և այն ամենով, ինչը կարող է հուզել դիտողներին: Բիզնեսի համար Tumblro-ն առաջարկում է ավելի հարմարեցված միջոց՝ իրենց արտադրանքը խթանելու համար

Արդյո՞ք Axios-ն ավելի լավն է, քան բերելը:

Axios-ը Javascript գրադարան է, որն օգտագործվում է հանգույցից http հարցումներ կատարելու համար: js կամ XMLHttp Խնդրում է զննարկիչից և այն աջակցում է Promise API-ին, որը բնօրինակ է JS ES6-ի համար: Մեկ այլ առանձնահատկություն, որն ունի ավարտված: fetch() այն է, որ այն կատարում է JSON տվյալների ավտոմատ փոխակերպումներ

Արդյո՞ք Dynamic Disk-ն ավելի լավն է, քան հիմնականը:

Դինամիկ սկավառակն ավելի շատ ճկունություն է տալիս, քան հիմնական սկավառակը, քանի որ այն չի օգտագործում բաժանման աղյուսակ բոլոր բաժանմունքներին հետևելու համար: Փոխարենը, այն օգտագործում է թաքնված տրամաբանական սկավառակի կառավարիչ (LDM) կամ վիրտուալ սկավառակի ծառայություն (VDS)՝ սկավառակի դինամիկ բաժանմունքների կամ ծավալների մասին տեղեկատվությունը հետևելու համար։

Արդյո՞ք iPad օդը ավելի լավն է, քան IPAD-ը:

IPad Air-ը շատ ավելի արագ է 10,2 դյույմանոց iPad-ը պարունակում է նույն A10 Fusionchip-ը, որը մենք գտանք անցյալ տարվա 9,7 դյույմանոց մոդելում, մինչդեռ iPadAir-ն ունի A12 Bionic չիպ, որն իր մեջ ներառում է Apple-ի երկրորդ սերնդի Neural Engine օպտիմիզացված մեքենայական ուսուցման համար: Դա բավականին ցատկ է

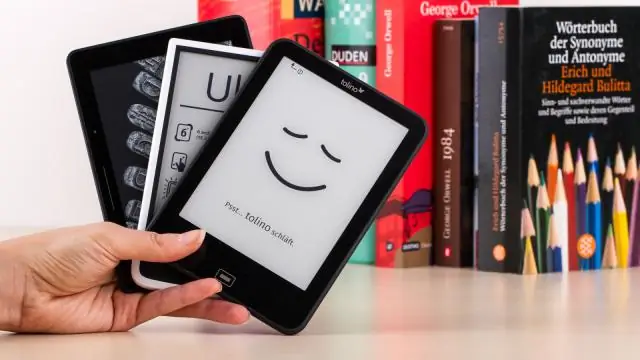

Արդյո՞ք էլեկտրոնային ընթերցողները ավելի լավն են, քան գրքերը:

2. Էլեկտրոնային գրքերն ավելի շարժական են, քան տպագիր: Տպագիր գրքերը, հատկապես կոշտ տպագրված հրատարակությունները, կարող են շատ ծանր լինել, մինչդեռ ժամանակակից eReader սարքերը թեթև են: Ավելի հեշտ է կրել էլեկտրոնային ընթերցող, որը պարունակում է վերնագրերի մի ամբողջ գրադարան, քան թեկուզ մի քանի ֆիզիկական գրքեր: