Բովանդակություն:

- Հեղինակ Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:48.

- Վերջին փոփոխված 2025-01-22 17:27.

Spark պատմության սերվերը միացնելու համար

- Ստեղծեք տեղեկատու իրադարձությունների տեղեկամատյանների համար DSEFS ֆայլային համակարգում՝ dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events:

- Երբ իրադարձությունների գրանցումը միացված է, լռելյայն վարքագիծն այն է, որ բոլոր տեղեկամատյանները պետք է պահպանվեն, ինչը հանգեցնում է պահուստի ավելացմանը ժամանակի ընթացքում:

Բացի դրանից, ինչպե՞ս կարող եմ կարգավորել Spark History սերվերը:

Spark պատմության սերվերը միացնելու համար

- Ստեղծեք տեղեկատու իրադարձությունների տեղեկամատյանների համար DSEFS ֆայլային համակարգում՝ dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events:

- Երբ իրադարձությունների գրանցումը միացված է, լռելյայն վարքագիծն այն է, որ բոլոր տեղեկամատյանները պետք է պահպանվեն, ինչը հանգեցնում է պահուստի ավելացմանը ժամանակի ընթացքում:

Նմանապես, ինչպե՞ս կարող եմ գտնել իմ Spark History սերվերի URL-ը: Օրինակ, համար պատմության սերվեր , դրանք սովորաբար հասանելի կլինեն սերվեր - url >:18080/api/v1, իսկ գործող հավելվածի համար՝ https://localhost:4040/api/v1: API-ում հավելվածը հիշատակվում է իր հավելվածի ID-ով, [app-id]:

Նմանապես, ի՞նչ է Spark History սերվերը:

Այն Spark պատմության սերվերն է մոնիտորինգի գործիք, որը ցուցադրում է ավարտվածի մասին տեղեկատվությունը Կայծ հավելվածներ։ Այս տեղեկությունը է քաղված է այն տվյալներից, որ հավելվածները լռելյայնորեն գրում են Hadoop բաշխված ֆայլային համակարգի (HDFS) գրացուցակում:

Ի՞նչ է Սպարկուին:

Spark Web UI-ն հնարավորություն է տալիս տեսնել ժամանակացույցի փուլերի և առաջադրանքների ցանկը, շրջակա միջավայրի մասին տեղեկատվություն, գործող կատարողների մասին տեղեկատվություն և այլն: Դիտեք այս 30 րոպեանոց ցուցադրությունը՝ իմանալու համար Spark ծրագրի բաղադրիչներն ու կյանքի ցիկլը: Ինչպես է ձեր Spark հավելվածն աշխատում Hadoop կլաստերի վրա:

Խորհուրդ ենք տալիս:

Ինչպե՞ս գործարկել GlassFish սերվերը հրամանի տողից:

GlassFish սերվերը հրամանի տողով գործարկելու համար GlassFish սերվերի միացքի համարը. լռելյայն 8080 է: Վարչական սերվերի պորտի համարը` լռելյայն 4848 է: Ադմինիստրացիայի օգտվողի անուն և գաղտնաբառ. Լռելյայն օգտագործողի անունն է admin, իսկ լռելյայն գաղտնաբառ չկա: պահանջվում է

Ինչպե՞ս սիրել ժանգով սերվերը:

Այնտեղից կբացվի պատուհան, կտտացրեք ձեր «Ընտրյալներ» ներդիրին: Դուք կտեսնեք, որ այն դատարկ է: Այստեղից կտտացրեք «Ավելացնել սերվեր» ձեր պատուհանի ներքևի աջ անկյունում: Այս քայլն ավարտելուց հետո ձեզ հետ կուղարկվեն ձեր սիրած սերվերի բրաուզերը

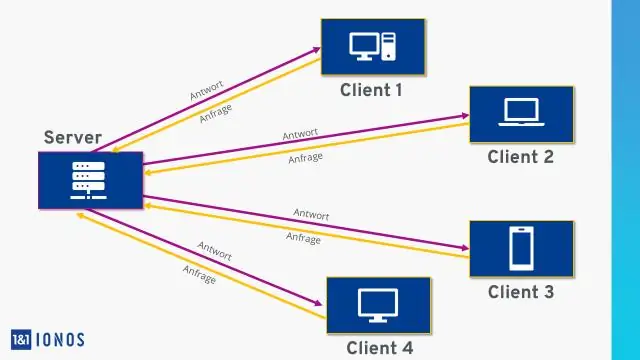

Ինչպե՞ս է աշխատում վեբ սերվերը:

Վեբ սերվերը մշակում է մուտքային ցանցային հարցումները HTTP-ի և մի քանի այլ հարակից արձանագրությունների միջոցով: Վեբ սերվերի առաջնային գործառույթը վեբ էջերի պահպանումն, մշակումն ու հաճախորդներին առաքումն է: Հաճախորդի և սերվերի միջև հաղորդակցությունը տեղի է ունենում Hypertext Transfer Protocol (HTTP) միջոցով:

Ինչպե՞ս կանգնեցնել հանգույցի սերվերը:

Դուք կարող եք դադարեցնել սերվերը՝ սպանելով գործընթացը: Windows-ում գործարկեք CMD-ն և մուտքագրեք taskkill /F /IM node.exe Սա կսպանի(կդադարեցնի) բոլոր հանգույցները: js գործընթացները: Եվ հետո կարող եք վերագործարկել այն

Ի՞նչ է վեբ սերվերը և հավելվածի սերվերը asp net-ում:

Վեբ սերվերի և հավելվածի սերվերի հիմնական տարբերությունն այն է, որ վեբ սերվերը նախատեսված է ստատիկ էջեր սպասարկելու համար, օրինակ. HTML և CSS, մինչդեռ Application Server-ը պատասխանատու է դինամիկ բովանդակություն ստեղծելու համար՝ կատարելով սերվերի կողմի կոդը, օրինակ. JSP, Servlet կամ EJB